口罩佩戴檢測

今年一場席卷全球的新型冠狀病毒給人們帶來了沉重的生命財產的損失。有效防御這種傳染病毒的方法就是積極佩戴口罩。我國對此也采取了嚴肅的措施,在公共場合要求人們必須佩戴口罩。在本次實驗中,我們要建立一個目標檢測的模型,可以識別圖中的人是否佩戴了口罩。

實驗使用重要_python_包:

import cv2 as cv

import numpy as np

import matplotlib.pyplot as plt

from tensorflow.keras.callbacks import ModelCheckpoint, ReduceLROnPlateau, EarlyStopping

由於擔心平台_GPU時長不夠用,所以在自己電腦上搭建了配套實驗環境,由於電腦顯卡CUDA_版本較老,所以最終本地配置如下:

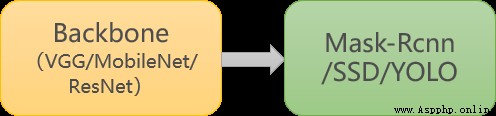

針對目標檢測的任務,可以分為兩個部分:目標識別和位置檢測。通常情況下,特征提取需要由特有的特征提取神經網絡來完成,如 VGG、MobileNet、ResNet 等,這些特征提取網絡往往被稱為 Backbone 。而在 BackBone 後面接全連接層***(FC)***就可以執行分類任務。但 FC 對目標的位置識別乏力。經過算法的發展,當前主要以特定的功能網絡來代替 FC 的作用,如 Mask-Rcnn、SSD、YOLO 等。我們選擇充分使用已有的人臉檢測的模型,再訓練一個識別口罩的模型,從而提高訓練的開支、增強模型的准確率。

常規目標檢測:

本次案例:

圖1 實驗口罩佩戴檢測流程

首先,導入已經寫好的_python_文件並對數據集進行處理。

將圖片尺寸調整到網絡輸入的圖片尺寸

圖片生成器的主要方法:

fit(x, augment=False, rounds=1):計算依賴於數據的變換所需要的統計信息(均值方差等)。

flow(self, X, y, batch_size=32, shuffle=True, seed=None, save_to_dir=None, save_prefix='', save_format='png'):接收 Numpy 數組和標簽為參數,生成經過數據提升或標准化後的 batch 數據,並在一個無限循環中不斷的返回 batch 數據。

flow_from_directory(directory): 以文件夾路徑為參數,會從路徑推測 label,生成經過數據提升/歸一化後的數據,在一個無限循環中無限產生 batch 數據。

結果:

Found 693 images belonging to 2 classes.

Found 76 images belonging to 2 classes.

{'mask': 0, 'nomask': 1}

{0: 'mask', 1: 'nomask'}

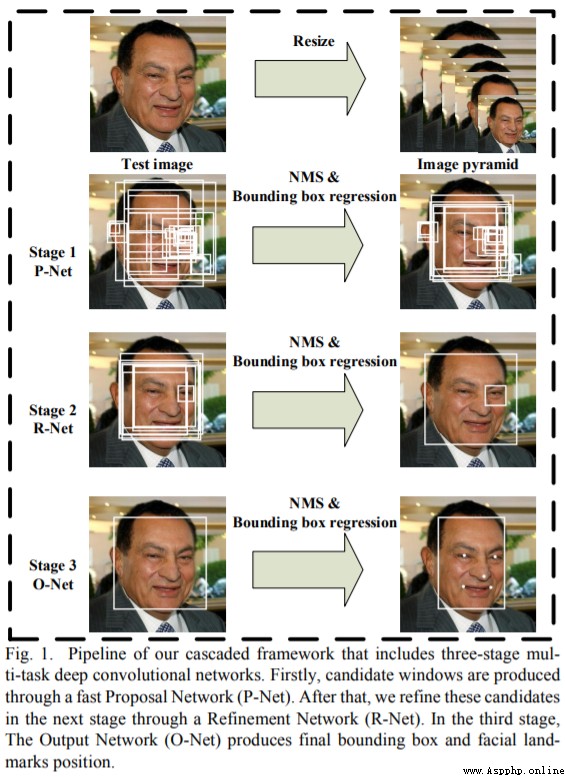

通過搭建 MTCNN 網絡實現人臉檢測

keras_py/mtcnn.py 文件是在搭建 MTCNN 網絡。

keras_py/face_rec.py 文件是在繪制人臉檢測的矩形框。

這裡直接使用現有的表現較好的 MTCNN 的三個權重文件,它們已經保存在

datasets/5f680a696ec9b83bb0037081-momodel/data/keras_model_data文件夾下

# 加載 MobileNet 的預訓練模型權重

weights_path = basic_path + 'keras_model_data/mobilenet_1_0_224_tf_no_top.h5'

為了避免訓練過程中遇到斷電等突發事件,導致模型訓練成果無法保存。我們可以通過 ModelCheckpoint 規定在固定迭代次數後保存模型。同時,我們設置在下一次重啟訓練時,會檢查是否有上次訓練好的模型,如果有,就先加載已有的模型權重。這樣就可以在上次訓練的基礎上繼續模型的訓練了。

學習率的手動設置可以使模型訓練更加高效。這裡我們設置當模型在三輪迭代後,准確率沒有上升,就調整學習率。

# 學習率下降的方式,acc三次不下降就下降學習率繼續訓練

reduce_lr = ReduceLROnPlateau(

monitor='accuracy', # 檢測的指標

factor=0.5, # 當acc不下降時將學習率下調的比例

patience=3, # 檢測輪數是每隔三輪

verbose=2 # 信息展示模式

)

當我們訓練深度學習神經網絡的時候通常希望能獲得最好的泛化性能。但是所有的標准深度學習神經網絡結構如全連接多層感知機都很容易過擬合。當網絡在訓練集上表現越來越好,錯誤率越來越低的時候,就極有可能出現了過擬合。早停法就是當我們在檢測到這一趨勢後,就停止訓練,這樣能避免繼續訓練導致過擬合的問題。

early_stopping = EarlyStopping(

monitor='val_accuracy', # 檢測的指標

min_delta=0.0001, # 增大或減小的阈值

patience=3, # 檢測的輪數頻率

verbose=1 # 信息展示的模式

)

打亂txt的行,這個txt主要用於幫助讀取數據來訓練,打亂的數據更有利於訓練。

np.random.seed(10101)

np.random.shuffle(lines)

np.random.seed(None)

一次訓練集大小設定為64,優化器使用Adam,初始學習率設定為0.001,優化目標為accuracy,總的學習輪次設定為20輪。(通過多次實驗測定,在這些參數條件下,准確率較高)

# 一次的訓練集大小

batch_size = 64

# 編譯模型

model.compile(loss='binary_crossentropy', # 二分類損失函數

optimizer=Adam(lr=0.001), # 優化器

metrics=['accuracy']) # 優化目標

# 訓練模型

history = model.fit(train_generator,

epochs=20, # epochs: 整數,數據的迭代總輪數。

# 一個epoch包含的步數,通常應該等於你的數據集的樣本數量除以批量大小。

steps_per_epoch=637 // batch_size,

validation_data=test_generator,

validation_steps=70 // batch_size,

initial_epoch=0, # 整數。開始訓練的輪次(有助於恢復之前的訓練)。

callbacks=[checkpoint_period, reduce_lr])

圖2 MTCNN架構

圖3 MobileNet架構

_MobileNet_的網絡結構如圖3所示。首先是一個3x3的標准卷積,然後後面就是堆積depthwise separable convolution,並且可以看到其中的部分depthwise convolution會通過strides=2進行down sampling。然後采用average pooling將feature變成1x1,根據預測類別大小加上全連接層,最後是一個softmax層。

最終確定最佳取值為batch_size=64,lr=0.0001,epochs=20,其它參數如下,連續訓練兩次,可以獲得最佳結果。此處僅展示兩個參數條件下的結果作為對比

# 一次的訓練集大小

batch_size = 64

# 編譯模型

model.compile(loss='binary_crossentropy', # 二分類損失函數

optimizer=Adam(lr=0.001), # 優化器

metrics=['accuracy']) # 優化目標

# 訓練模型

history = model.fit(train_generator,

epochs=20, # epochs: 整數,數據的迭代總輪數。

# 一個epoch包含的步數,通常應該等於你的數據集的樣本數量除以批量大小。

steps_per_epoch=637 // batch_size,

validation_data=test_generator,

validation_steps=70 // batch_size,

initial_epoch=0, # 整數。開始訓練的輪次(有助於恢復之前的訓練)。

callbacks=[checkpoint_period, reduce_lr])

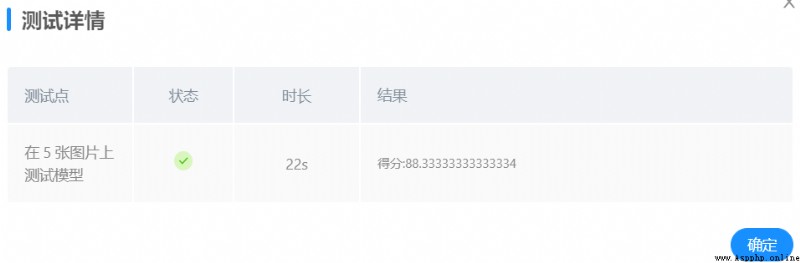

batch_size=48, lr=0.001,epochs=20,對訓練之後的模型進行測試,得到結果如下:

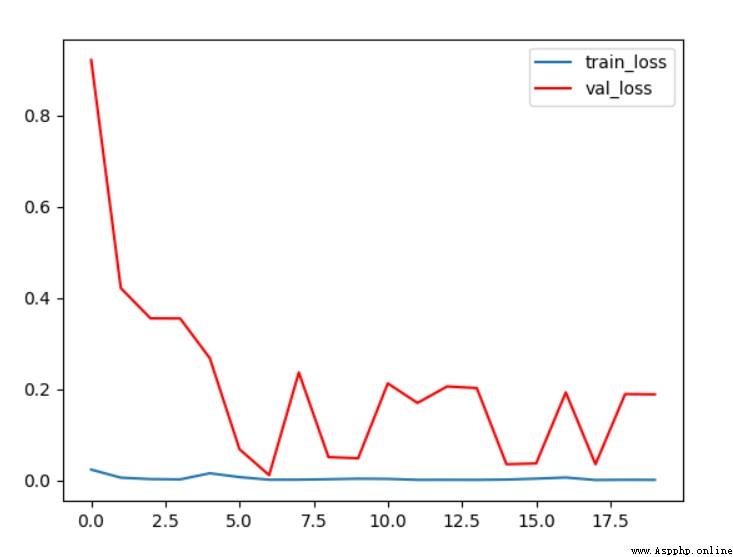

圖4 條件1 loss曲線

由loss曲線可以看出,隨著訓練迭代次數的加深,驗證集上的損失在逐漸的減小,最終穩定在0.2左右;而在訓練集上loss始終在0附近。

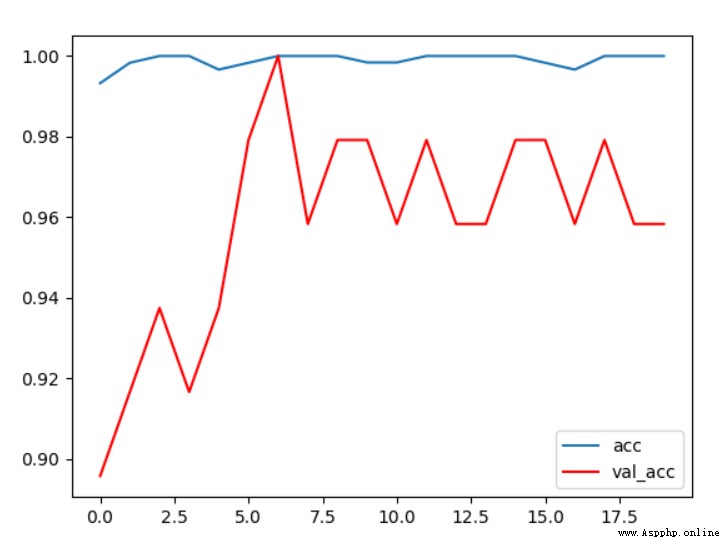

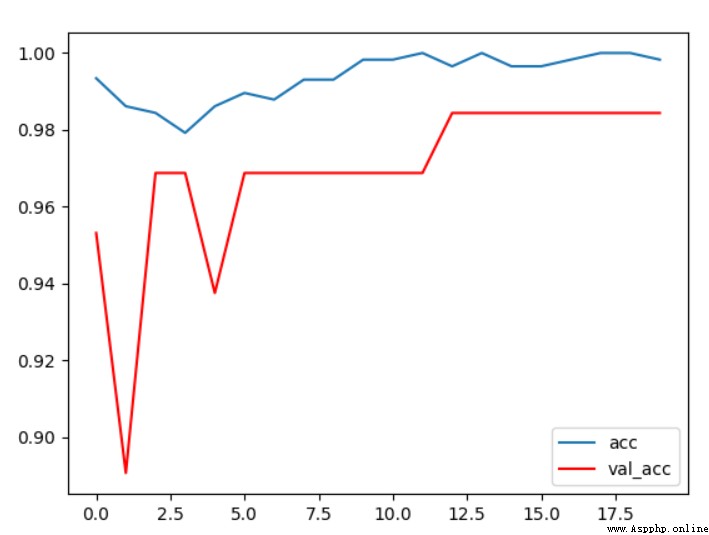

圖5 條件1 acc曲線

從驗證集和測試集的准確率變化曲線上可以看出,隨著訓練輪次的增加,驗證集的准確率逐漸上升,最終穩定在96%左右,效果還是不錯的。

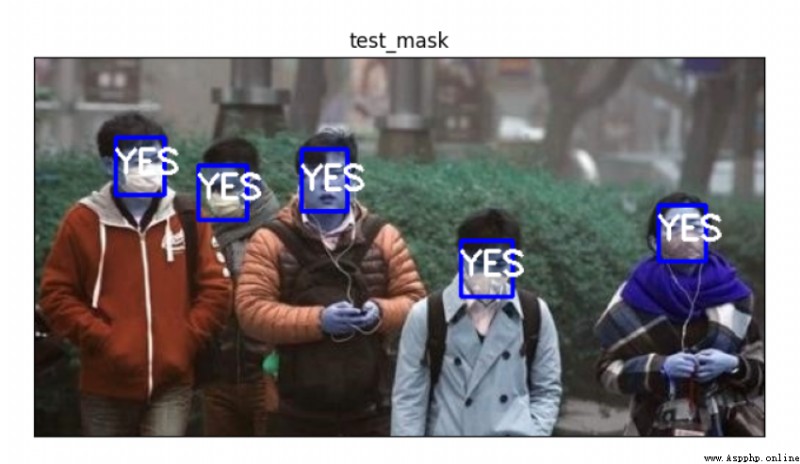

圖6 條件1 測試樣例1

使用樣例照片進行測試,首先人臉識別部分順利識別到了五張人臉,但是口罩識別部分將一個沒有帶口罩的人識別成了帶著口罩的人,說明還有進步空間,實際錯誤率達到了20%。

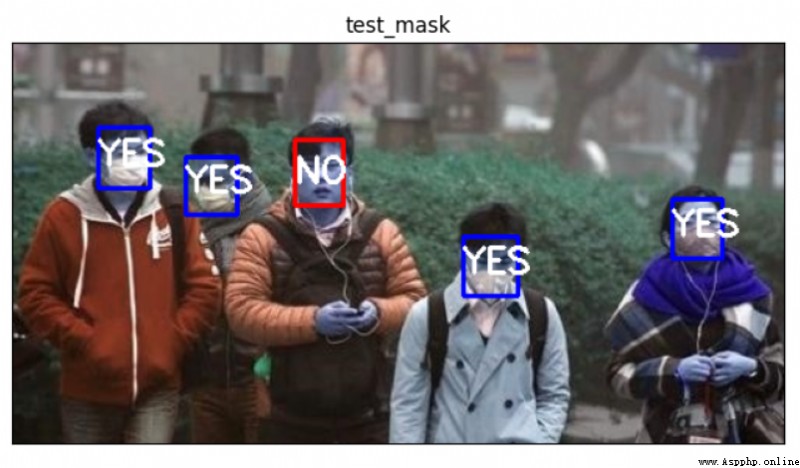

圖7 條件1 測試樣例2

另一張樣例照片的測試結果同樣是人臉識別部分沒有出現問題,正確識別到了四張人臉,但是同樣將一個沒有帶口罩的人識別成了帶有口罩的人。

後續通過調整各項參數並打亂測試集和訓練集圖片順序來進行了多次實驗,最終確定的最佳狀態如下:

batch_size=64, lr=0.0001,epochs=20,對訓練之後的模型進行測試,得到結果如下:

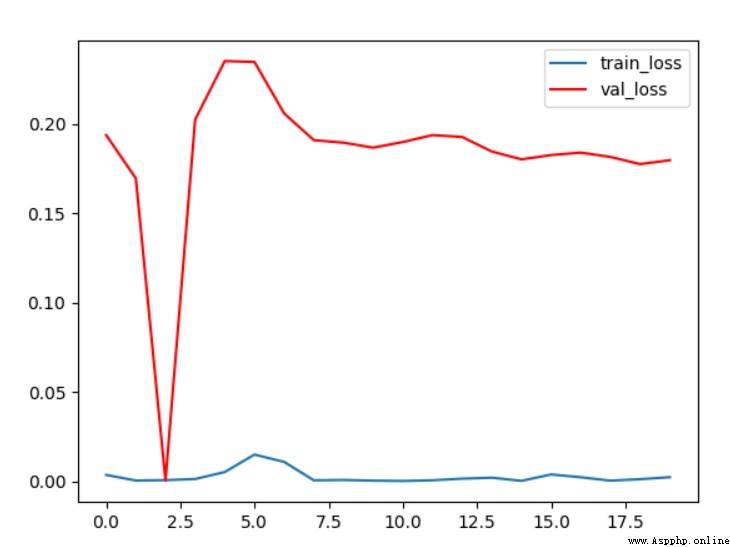

圖8 條件2 loss曲線

觀察准確率曲線可以看出,在該條件下,驗證集上的准確率最終穩定在98%附近,效果非常的好,說明我們做出的一些優化還是具有一定效果的。

圖9 條件2 acc曲線

觀察此條件下的loss曲線可以看到最終驗證集的loss穩定在0.2左右,訓練集的loss非常小,基本趨近於0

圖10 條件2 測試樣例1

使用兩張測試樣例對模型進行檢測,第一張圖片所有檢測點均正確,正確識別出了五張人臉並且口罩佩戴檢測均正確,識別正確率100%。

圖11 條件2 測試樣例2

第二章測試樣例上,正確識別出了4張人臉並且口罩佩戴檢測結果均正確。

兩張測試樣例上所有檢測點檢測結果均正確,說明在此參數條件下,模型識別效果較好,達到了口罩佩戴檢測的要求。

使用更多測試樣例發現_MTCNN_人臉識別部分存在不能正確識別人臉的問題,故通過多次實驗和測試,修改了mask_rec()的門限函數權重self.threshold,由原來的self.threshold = [0.5,0.6,0.8] 修改為self.threshold = [0.4,0.15,0.65]

在本地使用更多自選圖片進行測試,發現人臉識別准確率有所提升。在條件2訓練參數不變的情況下,使用同一模型進行平台測試,結果如下:

平台測試成績有所提升。

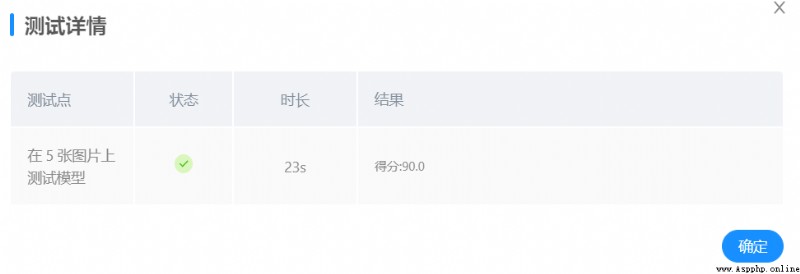

繼續調整mask_rec()的門限函數權重self.threshold,通過系統測試反饋來決定門限函數的權重,通過多次測試,由原來的self.threshold = [0.4,0.15,0.65] 修改為self.threshold = [0.4,0.6,0.65]

平台測試,結果如下:

平台測試成績有所提升,達到95分。

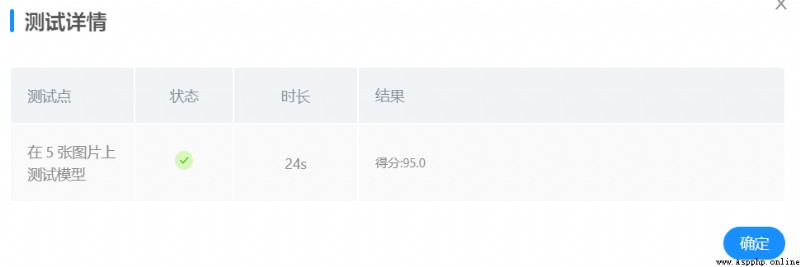

為了達到條件4所展示的效果,對門限函數的數值進行了大量的嘗試,根據提交測試的反饋結果,最終確定數值為條件4時,可以達到最優。由於不知道後台測試圖片是什麼且沒有反饋數據,所以最終再次修改人臉識別的門限函數或者修改參數重新訓練口罩識別模型依舊沒有提升。

驗證集准確率

測試樣例結果

平台成績

條件1

96%

7/9

77.5

條件2

98%

9/9

88.33333334

條件3

98%

9/9

90

條件4

98%

9/9

95

最終通過不斷調試與優化算法,得到了95分的平台成績。

本次實驗過程中主要使用了_keras方法進行訓練,由於初次使用這些方法,所以前期實現的過程相對困難。最初我想通過調用GPU資源來進行訓練,所以給自己的電腦配套安裝了tensorflow-gpu、CUDA等等配套的軟件和包,由於個人電腦的顯卡版本較老,所以安裝的過程也是非常的曲折。好在最終安裝好了所有的東西,但是由於顯卡顯存比較小,所以bath_size大小一直上不去,最大只能給到32,不過影響也不大。調整參數的過程花費了很多的時間,優化算法也花費了很多的時間。之後又對門限函數進行了修改,雖然過程非常的辛苦,但最終的結果還是很不錯的,最終整體達到95_分,在兩張給定的測試樣例上所有檢測點都是正確的,由於不知道平台的五張檢測照片是什麼,所以不知道到底出錯在哪裡,希望之後平台可以反饋一些修改意見~。總的來說在過程中收獲還是很大的,受益匪淺。

訓練源代碼:

import warnings

# 忽視警告

warnings.filterwarnings('ignore')

import os

import matplotlib

import cv2 as cv

import numpy as np

import matplotlib.pyplot as plt

from tensorflow.keras.callbacks import ModelCheckpoint, ReduceLROnPlateau, EarlyStopping

from tensorflow.keras.applications.imagenet_utils import preprocess_input

from tensorflow.keras import backend as K

from tensorflow.keras.optimizers import Adam

K.image_data_format() == 'channels_last'

from keras_py.utils import get_random_data

from keras_py.face_rec import mask_rec

from keras_py.face_rec import face_rec

from keras_py.mobileNet import MobileNet

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# 數據集路徑

basic_path = "./datasets/5f680a696ec9b83bb0037081-momodel/data/"

def letterbox_image(image, size): # 調整圖片尺寸,返回經過調整的照片

new_image = cv.resize(image, size, interpolation=cv.INTER_AREA)

return new_image

read_img = cv.imread("test1.jpg")

print("調整前圖片的尺寸:", read_img.shape)

read_img = letterbox_image(image=read_img, size=(50, 50))

print("調整前圖片的尺寸:", read_img.shape)

def processing_data(data_path, height, width, batch_size=32, test_split=0.1): # 數據處理,batch_size默認大小為32

train_data = ImageDataGenerator(

# 對圖片的每個像素值均乘上這個放縮因子,把像素值放縮到0和1之間有利於模型的收斂

rescale=1. / 255,

# 浮點數,剪切強度(逆時針方向的剪切變換角度)

shear_range=0.1,

# 隨機縮放的幅度,若為浮點數,則相當於[lower,upper] = [1 - zoom_range, 1+zoom_range]

zoom_range=0.1,

# 浮點數,圖片寬度的某個比例,數據提升時圖片水平偏移的幅度

width_shift_range=0.1,

# 浮點數,圖片高度的某個比例,數據提升時圖片豎直偏移的幅度

height_shift_range=0.1,

# 布爾值,進行隨機水平翻轉

horizontal_flip=True,

# 布爾值,進行隨機豎直翻轉

vertical_flip=True,

# 在 0 和 1 之間浮動。用作驗證集的訓練數據的比例

validation_split=test_split

)

# 接下來生成測試集,可以參考訓練集的寫法

test_data = ImageDataGenerator(

rescale=1. / 255,

validation_split=test_split)

train_generator = train_data.flow_from_directory(

# 提供的路徑下面需要有子目錄

data_path,

# 整數元組 (height, width),默認:(256, 256)。 所有的圖像將被調整到的尺寸。

target_size=(height, width),

# 一批數據的大小

batch_size=batch_size,

# "categorical", "binary", "sparse", "input" 或 None 之一。

# 默認:"categorical",返回one-hot 編碼標簽。

class_mode='categorical',

# 數據子集 ("training" 或 "validation")

subset='training',

seed=0)

test_generator = test_data.flow_from_directory(

data_path,

target_size=(height, width),

batch_size=batch_size,

class_mode='categorical',

subset='validation',

seed=0)

return train_generator, test_generator

# 數據路徑

data_path = basic_path + 'image'

# 圖像數據的行數和列數

height, width = 160, 160

# 獲取訓練數據和驗證數據集

train_generator, test_generator = processing_data(data_path, height, width)

# 通過屬性class_indices可獲得文件夾名與類的序號的對應字典。

labels = train_generator.class_indices

print(labels)

# 轉換為類的序號與文件夾名對應的字典

labels = dict((v, k) for k, v in labels.items())

print(labels)

pnet_path = "./datasets/5f680a696ec9b83bb0037081-momodel/data/keras_model_data/pnet.h5"

rnet_path = "./datasets/5f680a696ec9b83bb0037081-momodel/data/keras_model_data/rnet.h5"

onet_path = "./datasets/5f680a696ec9b83bb0037081-momodel/data/keras_model_data/onet.h5"

# 加載 MobileNet 的預訓練模型權重

weights_path = basic_path + 'keras_model_data/mobilenet_1_0_224_tf_no_top.h5'

# 圖像數據的行數和列數

height, width = 160, 160

model = MobileNet(input_shape=[height,width,3],classes=2)

model.load_weights(weights_path,by_name=True)

print('加載完成...')

def save_model(model, checkpoint_save_path, model_dir): # 保存模型

if os.path.exists(checkpoint_save_path):

print("模型加載中")

model.load_weights(checkpoint_save_path)

print("模型加載完畢")

checkpoint_period = ModelCheckpoint(

# 模型存儲路徑

model_dir + 'ep{epoch:03d}-loss{loss:.3f}-val_loss{val_loss:.3f}.h5',

# 檢測的指標

monitor='val_acc',

# ‘auto’,‘min’,‘max’中選擇

mode='max',

# 是否只存儲模型權重

save_weights_only=False,

# 是否只保存最優的模型

save_best_only=True,

# 檢測的輪數是每隔2輪

period=2

)

return checkpoint_period

checkpoint_save_path = "./results/last_one88.h5"

model_dir = "./results/"

checkpoint_period = save_model(model, checkpoint_save_path, model_dir)

# 學習率下降的方式,acc三次不下降就下降學習率繼續訓練

reduce_lr = ReduceLROnPlateau(

monitor='accuracy', # 檢測的指標

factor=0.5, # 當acc不下降時將學習率下調的比例

patience=3, # 檢測輪數是每隔三輪

verbose=2 # 信息展示模式

)

early_stopping = EarlyStopping(

monitor='val_accuracy', # 檢測的指標

min_delta=0.0001, # 增大或減小的阈值

patience=3, # 檢測的輪數頻率

verbose=1 # 信息展示的模式

)

# 一次的訓練集大小

batch_size = 64

# 圖片數據路徑

data_path = basic_path + 'image'

# 圖片處理

train_generator, test_generator = processing_data(data_path, height=160, width=160, batch_size=batch_size, test_split=0.1)

# 編譯模型

model.compile(loss='binary_crossentropy', # 二分類損失函數

optimizer=Adam(lr=0.001), # 優化器

metrics=['accuracy']) # 優化目標

# 訓練模型

history = model.fit(train_generator,

epochs=20, # epochs: 整數,數據的迭代總輪數。

# 一個epoch包含的步數,通常應該等於你的數據集的樣本數量除以批量大小。

steps_per_epoch=637 // batch_size,

validation_data=test_generator,

validation_steps=70 // batch_size,

initial_epoch=0, # 整數。開始訓練的輪次(有助於恢復之前的訓練)。

callbacks=[checkpoint_period, reduce_lr])

# 保存模型

model.save_weights(model_dir + 'temp.h5')

plt.plot(history.history['loss'],label = 'train_loss')

plt.plot(history.history['val_loss'],'r',label = 'val_loss')

plt.legend()

plt.show()

plt.plot(history.history['accuracy'],label = 'acc')

plt.plot(history.history['val_accuracy'],'r',label = 'val_acc')

plt.legend()

plt.show()

Python tutorial 88-- accounting tutorial 8- cost analysis pandas_ Using the profiling Library

Python tutorial 88-- accounting tutorial 8- cost analysis pandas_ Using the profiling Library

Use pandas_profiling Th

27 Python artificial intelligence libraries have been sorted out. How many have you learned

27 Python artificial intelligence libraries have been sorted out. How many have you learned

In order that we can understan