一、Memcache內存分配機制

關於這個機制網上有很多解釋的,我個人的總結如下。

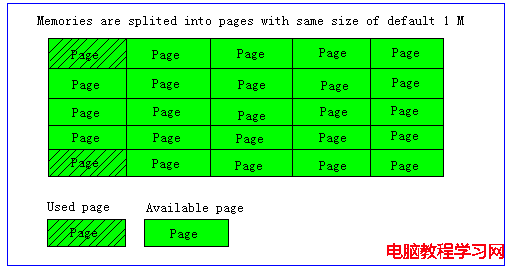

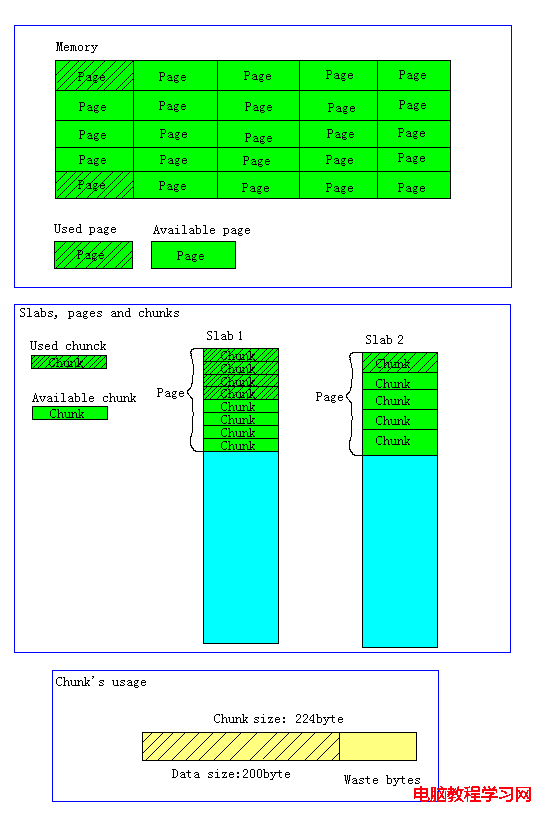

Memcached的內存分配以page為單位,默認情況下一個page是1M,可以通過-I參數在啟動時指定。如果需要申請內存時,memcached會劃分出一個新的page並分配給需要的slab區域。page一旦被分配在重啟前不會被回收或者重新分配(page ressign已經從1.2.8版移除了)

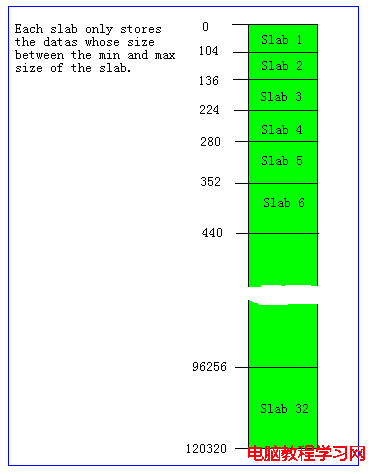

Memcached並不是將所有大小的數據都放在一起的,而是預先將數據空間劃分為一系列slabs,每個slab只負責一定范圍內的數據存儲。如下圖,每個slab只存儲大於其上一個slab的size並小於或者等於自己最大size的數據。例如:slab 3只存儲大小介於137 到 224 bytes的數據。如果一個數據大小為230byte將被分配到slab 4中。從下圖可以看出,每個slab負責的空間其實是不等的,memcached默認情況下下一個slab的最大值為前一個的1.25倍,這個可以通過修改-f參數來修改增長比例。

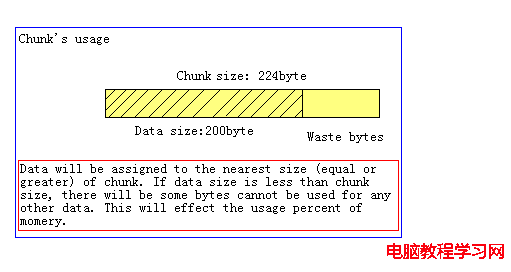

Chunk是一系列固定的內存空間,這個大小就是管理它的slab的最大存放大小。例如:slab 1的所有chunk都是104byte,而slab 4的所有chunk都是280byte。chunk是memcached實際存放緩存數據的地方,因為chunk的大小固定為slab能夠存放的最大值,所以所有分配給當前slab的數據都可以被chunk存下。如果時間的數據大小小於chunk的大小,空余的空間將會被閒置,這個是為了防止內存碎片而設計的。例如下圖,chunk size是224byte,而存儲的數據只有200byte,剩下的24byte將被閒置。

Memcached在啟動時通過-m指定最大使用內存,但是這個不會一啟動就占用,是隨著需要逐步分配給各slab的。

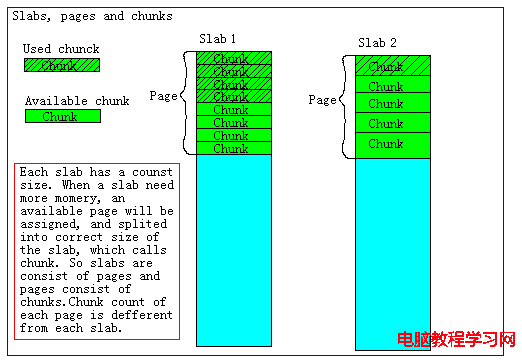

如果一個新的緩存數據要被存放,memcached首先選擇一個合適的slab,然後查看該slab是否還有空閒的chunk,如果有則直接存放進去;如果沒有則要進行申請。slab申請內存時以page為單位,所以在放入第一個數據,無論大小為多少,都會有1M大小的page被分配給該slab。申請到page後,slab會將這個page的內存按chunk的大小進行切分,這樣就變成了一個chunk的數組,在從這個chunk數組中選擇一個用於存儲數據。如下圖,slab 1和slab 2都分配了一個page,並按各自的大小切分成chunk數組。

綜合上面的介紹,memcached的內存分配策略就是:按slab需求分配page,各slab按需使用chunk存儲。

這裡有幾個特點要注意,

知道了這些以後,就可以理解為什麼總內存沒有被全部占用的情況下,memcached卻出現了丟失緩存數據的問題了。