MySQL不支持多主服務器復制(Multimaster Replication)——即一個slave可以有多個master。但是,通過一些簡單的組合,我們卻可以建立靈活而強大的復制體系結構。

在實際應用場景中,MySQL復制90%以上都是一個Master復制到一個或者多個Slave的架構模式,主要用於讀壓力比較大的應用的數據庫端廉價擴展解決方案。因為只要Master和Slave的壓力不是太大(尤其是Slave端壓力)的話,異步復制的延時一般都很少很少。尤其是自從Slave端的復制方式改成兩個線程處理之後,更是減小了Slave端的延時問題。而帶來的效益是,對於數據實時性要求不是特別Critical的應用,只需要通過廉價的pcserver來擴展Slave的數量,將讀壓力分散到多台Slave的機器上面,即可通過分散單台數據庫服務器的讀壓力來解決數據庫端的讀性能瓶頸,畢竟在大多數數據庫應用系統中的讀壓力還是要比寫壓力大很多。這在很大程度上解決了目前很多中小型網站的數據庫壓力瓶頸問題,甚至有些大型網站也在使用類似方案解決數據庫瓶頸。

如下:

大家應該都比較清楚,從一個Master節點可以復制出多個Slave節點,可能有人會想,那一個Slave節點是否可以從多個Master節點上面進行復制呢?至少在目前來看,MySQL是做不到的,以後是否會支持就不清楚了。

MySQL不支持一個Slave節點從多個Master節點來進行復制的架構,主要是為了避免沖突的問題,防止多個數據源之間的數據出現沖突,而造成最後數據的不一致性。不過聽說已經有人開發了相關的patch,讓MySQL支持一個Slave節點從多個Master結點作為數據源來進行復制,這也正是MySQL開源的性質所帶來的好處。

可能有些讀者朋友會有一個擔心,log-slave-updates 選項就是讓slave把replication的事件也寫進binlog,如果在互為主從的架構下,開始log-slave-updates不就會導致一個事務在兩個mysql之間不斷循環嗎?實際上MySQL自己早就想到了這一點,所以在MySQL的BinaryLog中記錄了當前MySQL的server-id,而且這個參數也是我們搭建MySQLReplication的時候必須明確指定,而且Master和Slave的server-id參數值比需要不一致才能使MySQLReplication搭建成功。一旦有了server-id的值之後,MySQL就很容易判斷某個變更是從哪一個MySQLServer最初產生的,所以就很容易避免出現循環復制的情況。而且,如果我們不打開記錄Slave的BinaryLog的選項(--log-slave-update)的時候,MySQL根本就不會記錄復制過程中的變更到BinaryLog中,就更不用擔心可能會出現循環復制的情形了。

如圖:

主動的Master-Master復制有一些特殊的用處。例如,地理上分布的兩個部分都需要自己的可寫的數據副本。這種結構最大的問題就是更新沖突。假設一個表只有一行(一列)的數據,其值為1,如果兩個服務器分別同時執行如下語句:

在第一個服務器上執行:

mysql> UPDATE tbl SET col=col + 1;

在第二個服務器上執行:

mysql> UPDATE tbl SET col=col * 2;

那麼結果是多少呢?一台服務器是4,另一個服務器是3,但是,這並不會產生錯誤。

實際上,MySQL並不支持其它一些DBMS支持的多主服務器復制(Multimaster Replication),這是MySQL的復制功能很大的一個限制(多主服務器的難點在於解決更新沖突),但是,如果你實在有這種需求,你可以采用MySQL Cluster,以及將Cluster和Replication結合起來,可以建立強大的高性能的數據庫平台。但是,可以通過其它一些方式來模擬這種多主服務器的復制。

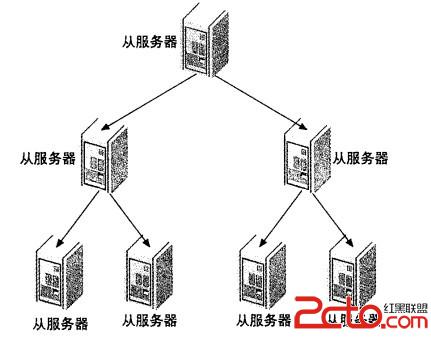

在有些應用場景中,可能讀寫壓力差別比較大,讀壓力特別的大,一個Master可能需要上10台甚至更多的Slave才能夠支撐注讀的壓力。這時候,Master就會比較吃力了,因為僅僅連上來的SlaveIO線程就比較多了,這樣寫的壓力稍微大一點的時候,Master端因為復制就會消耗較多的資源,很容易造成復制的延時。

遇到這種情況如何解決呢?這時候我們就可以利用MySQL可以在Slave端記錄復制所產生變更的BinaryLog信息的功能,也就是打開—log-slave-update選項。然後,通過二級(或者是更多級別)復制來減少Master端因為復制所帶來的壓力。也就是說,我們首先通過少數幾台MySQL從Master來進行復制,這幾台機器我們姑且稱之為第一級Slave集群,然後其他的Slave再從第一級Slave集群來進行復制。從第一級Slave進行復制的Slave,我稱之為第二級Slave集群。如果有需要,我們可以繼續往下增加更多層次的復制。這樣,我們很容易就控制了每一台MySQL上面所附屬Slave的數量。這種架構我稱之為Master-Slaves-Slaves架構

這種多層級聯復制的架構,很容易就解決了Master端因為附屬Slave太多而成為瓶頸的風險。下圖展示了多層級聯復制的Replication架構。

當然,如果條件允許,我更傾向於建議大家通過拆分成多個Replication集群來解決

上述瓶頸問題。畢竟Slave並沒有減少寫的量,所有Slave實際上仍然還是應用了所有的數據變更操作,沒有減少任何寫IO。相反,Slave越多,整個集群的寫IO總量也就會越多,我們沒有非常明顯的感覺,僅僅只是因為分散到了多台機器上面,所以不是很容易表現出來。

此外,增加復制的級聯層次,同一個變更傳到最底層的Slave所需要經過的MySQL也會更多,同樣可能造成延時較長的風險。

而如果我們通過分拆集群的方式來解決的話,可能就會要好很多了,當然,分拆集群也需要更復雜的技術和更復雜的應用系統架構。

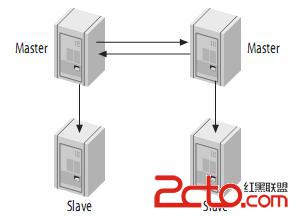

級聯復制在一定程度上面確實解決了Master因為所附屬的Slave過多而成為瓶頸的問題,但是他並不能解決人工維護和出現異常需要切換後可能存在重新搭建Replication的問題。這樣就很自然的引申出了DualMaster與級聯復制結合的Replication架構,我稱之為Master-Master-Slaves架構

和Master-Slaves-Slaves架構相比,區別僅僅只是將第一級Slave集群換成了一台單獨的Master,作為備用Master,然後再從這個備用的Master進行復制到一個Slave集群。

這種DualMaster與級聯復制結合的架構,最大的好處就是既可以避免主Master的寫入操作不會受到Slave集群的復制所帶來的影響,同時主Master需要切換的時候也基本上不會出現重搭Replication的情況。但是,這個架構也有一個弊端,那就是備用的Master有可能成為瓶頸,因為如果後面的Slave集群比較大的話,備用Master可能會因為過多的SlaveIO線程請求而成為瓶頸。當然,該備用Master不提供任何的讀服務的時候,瓶頸出現的可能性並不是特別高,如果出現瓶頸,也可以在備用Master後面再次進行級聯復制,架設多層Slave集群。當然,級聯復制的級別越多,Slave集群可能出現的數據延時也會更為明顯,所以考慮使用多層級聯復制之前,也需要評估數據延時對應用系統的影響。